【ニューラルネットワークの基礎研究16】

関数形ごとの学習成果の比較

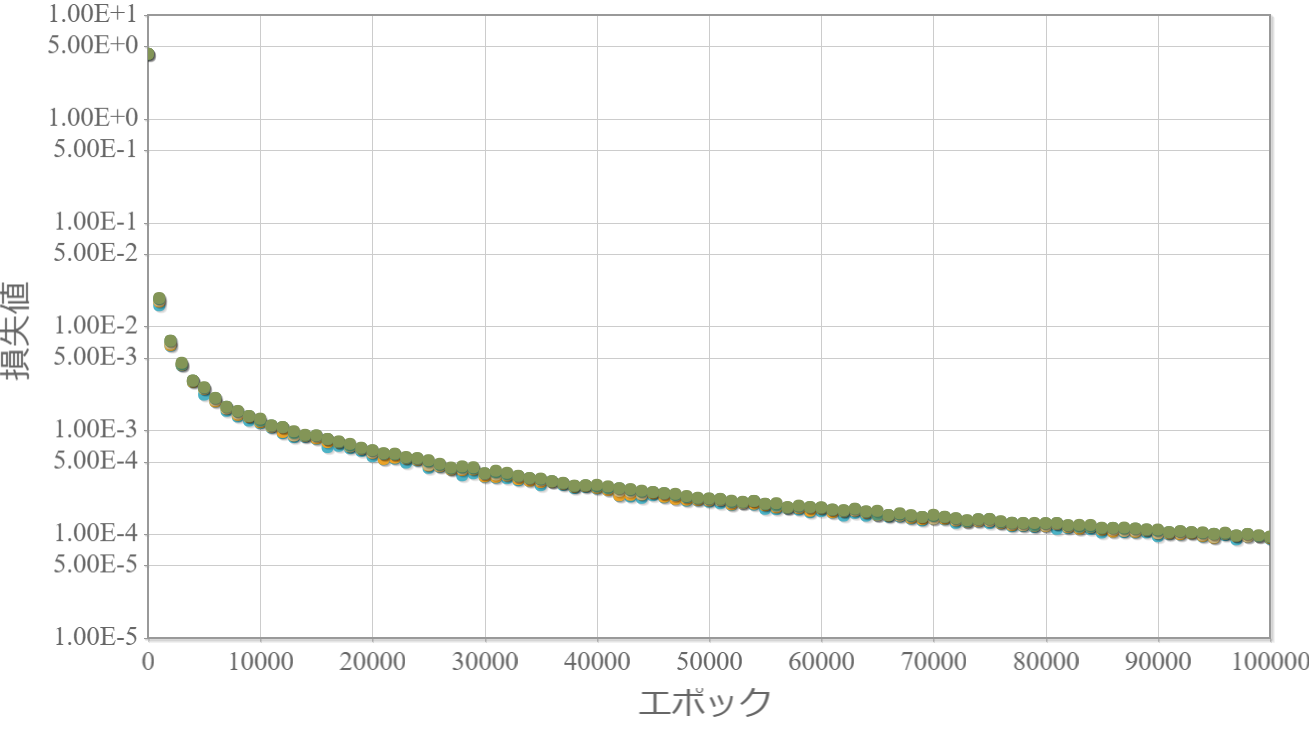

ここまで、「係数が変化する2次関数」「指数が変化するべき関数」「底が変化する指数関数」をニューラルネットワークの学習対象として、順方向伝播型の様々な構造の学習回数に対する損失値の計算を行いました。本稿ではこれまでの計算結果から関数形ごとの学習成果(中間1層、中間2層、中間8層)の比較しておきます。

【これまでの結果】

→ 1変数の2次関数の学習 1 2 3 4

→ 係数が変化する2次関数の学習 1 2 3 4

→ べきが変化するべき関数の学習 1 2 3

→ 学習効果を高めるにはディープ(層数)と並列数(ユニット数)のどちらが有効か?

→ 底が変化する指数関数の学習 1 2 3

ニューラルネットワークの基本パラメータ

・ニューラルネットワークの構造:順伝播型ニューラルネットワーク(FFNN)

・学習方法:通常の勾配法(学習率固定、逆誤差伝搬法)

・学習率:eta = 0.01;

・ミニバッチ数:100 (サンプルは無限に用意できるためミニバッチという概念は存在しませんが、ランダムに用意したミニバッチ数分のサンプルに対する平均を用いて学習を進める)

・活性化関数(中間層):ReLU(ランプ関数)

・活性化関数(出力層):恒等関数

・損失関数:2乗和

※独立したネットワークを10個用意してそれぞれ個別に学習させて、学習効果の高かった上位5つの「学習回数」vs「損失値」をグラフ化します。

※参考ページ

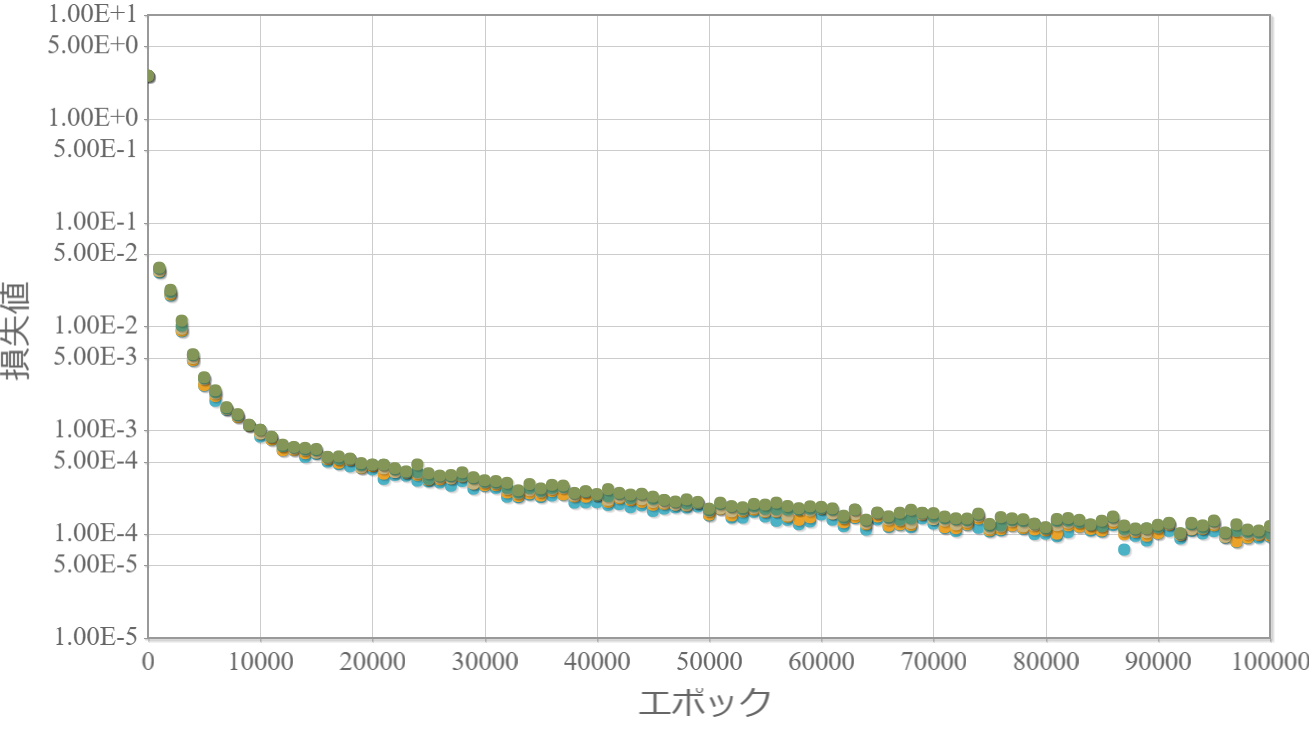

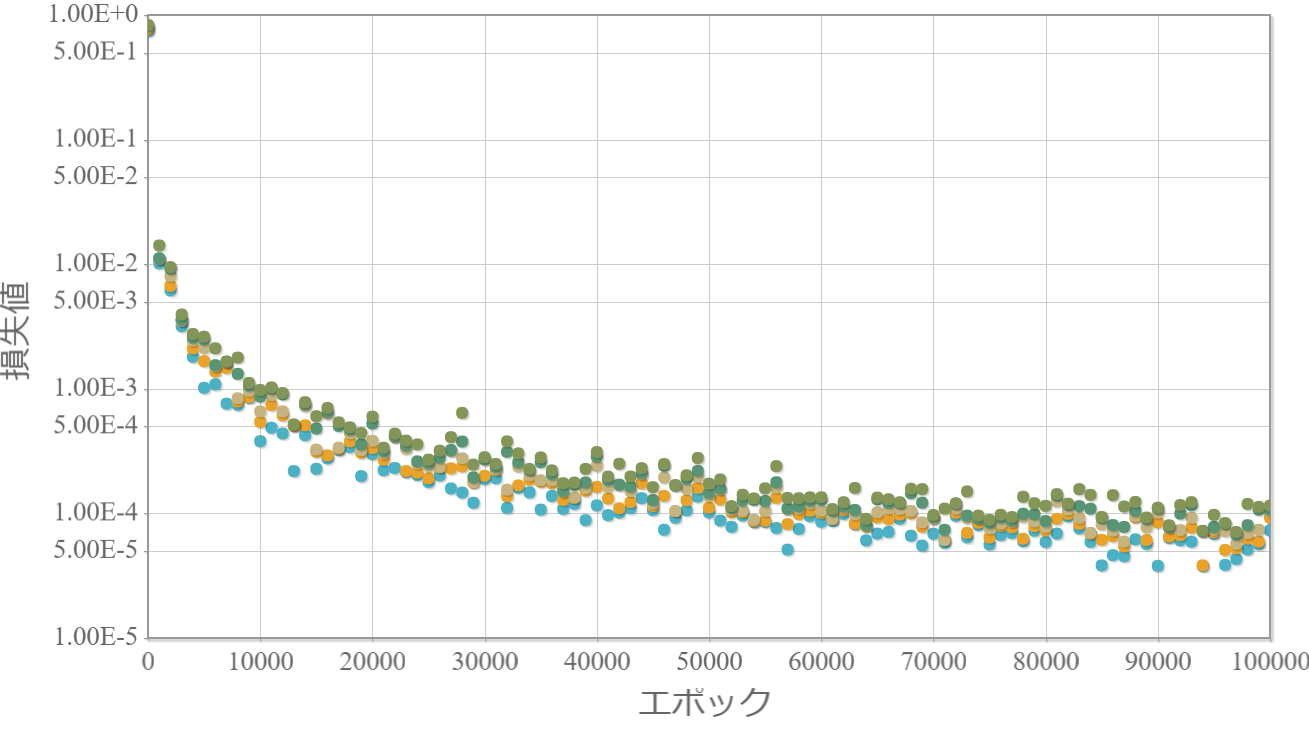

【2-1000-1】型の比較

2次関数(係数が変化)

べき関数(指数が変化)

指数関数(底が変化)

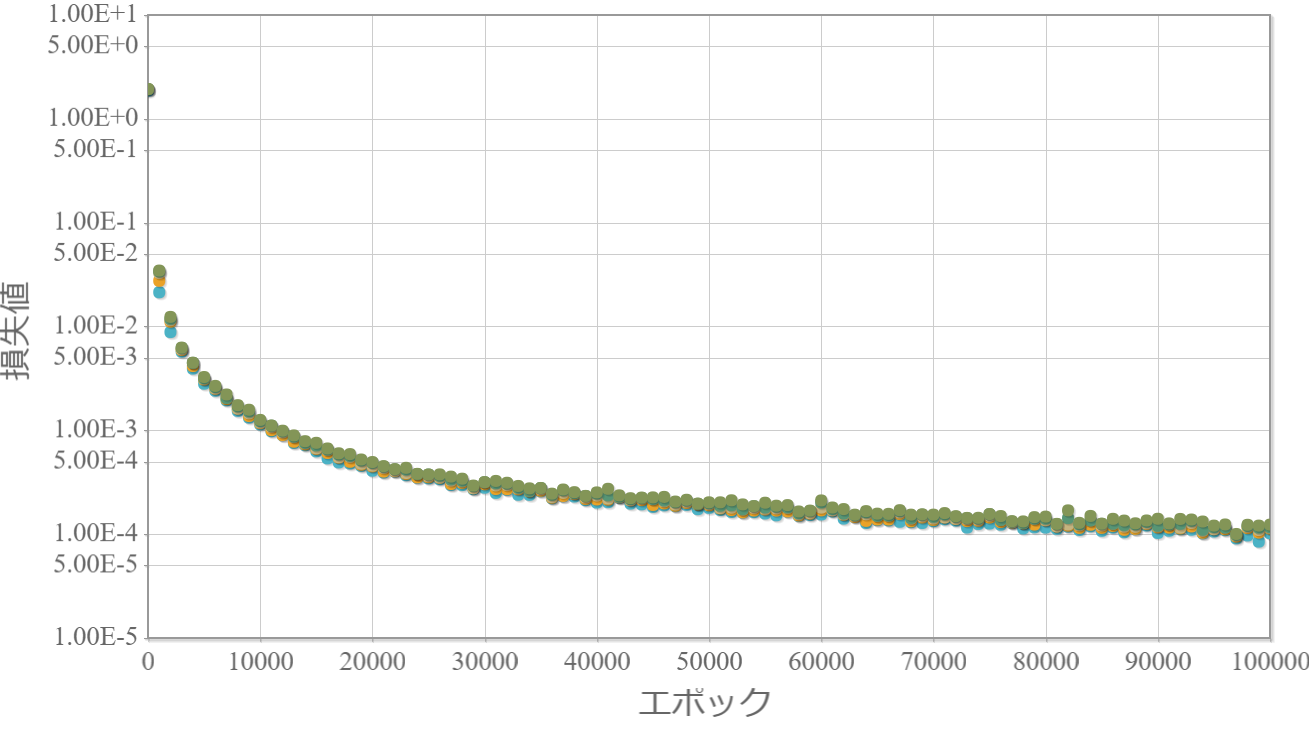

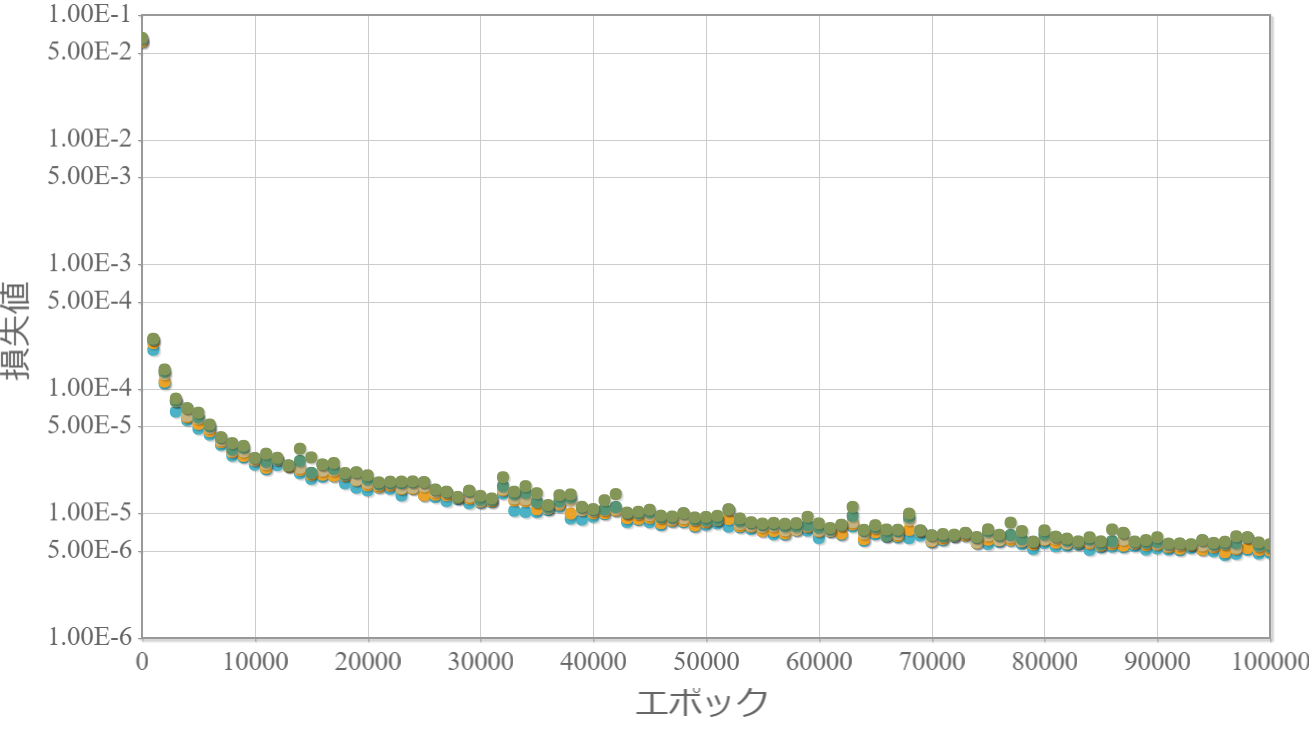

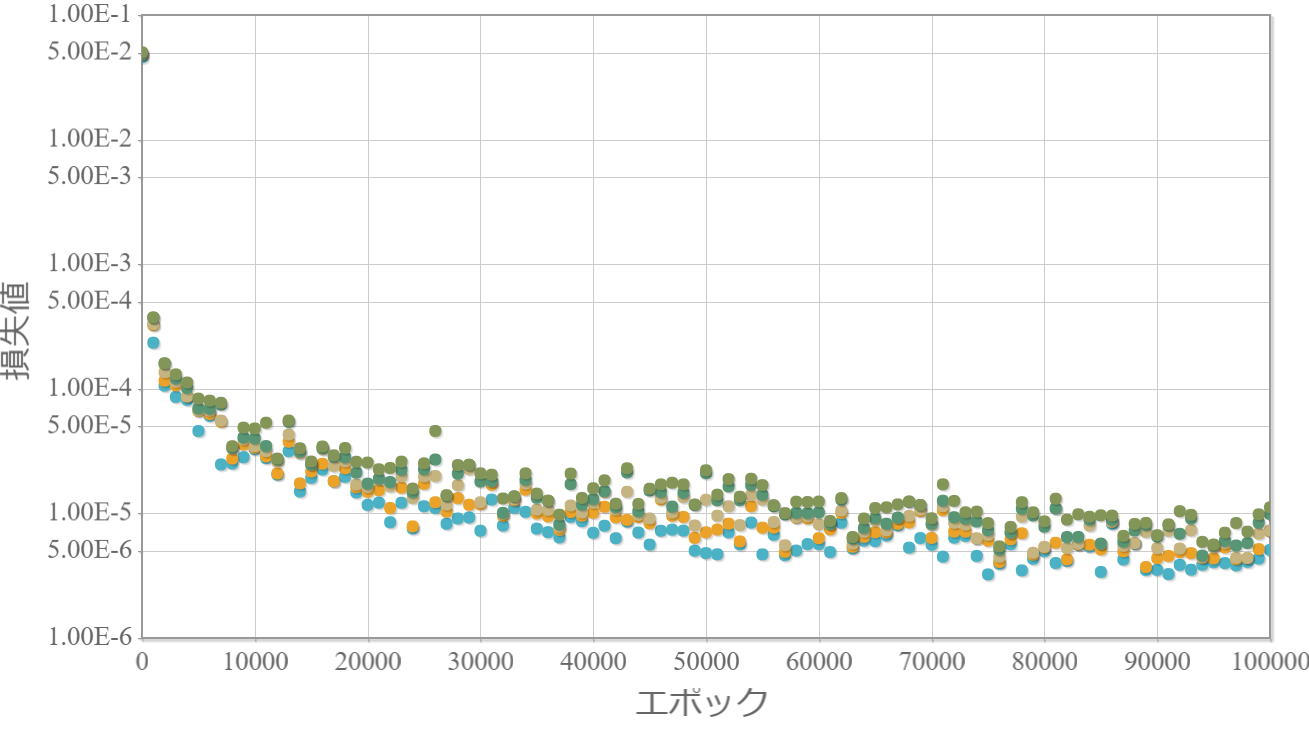

【2-200-200-1】型の比較

2次関数(係数が変化)

べき関数(指数が変化)

指数関数(底が変化)

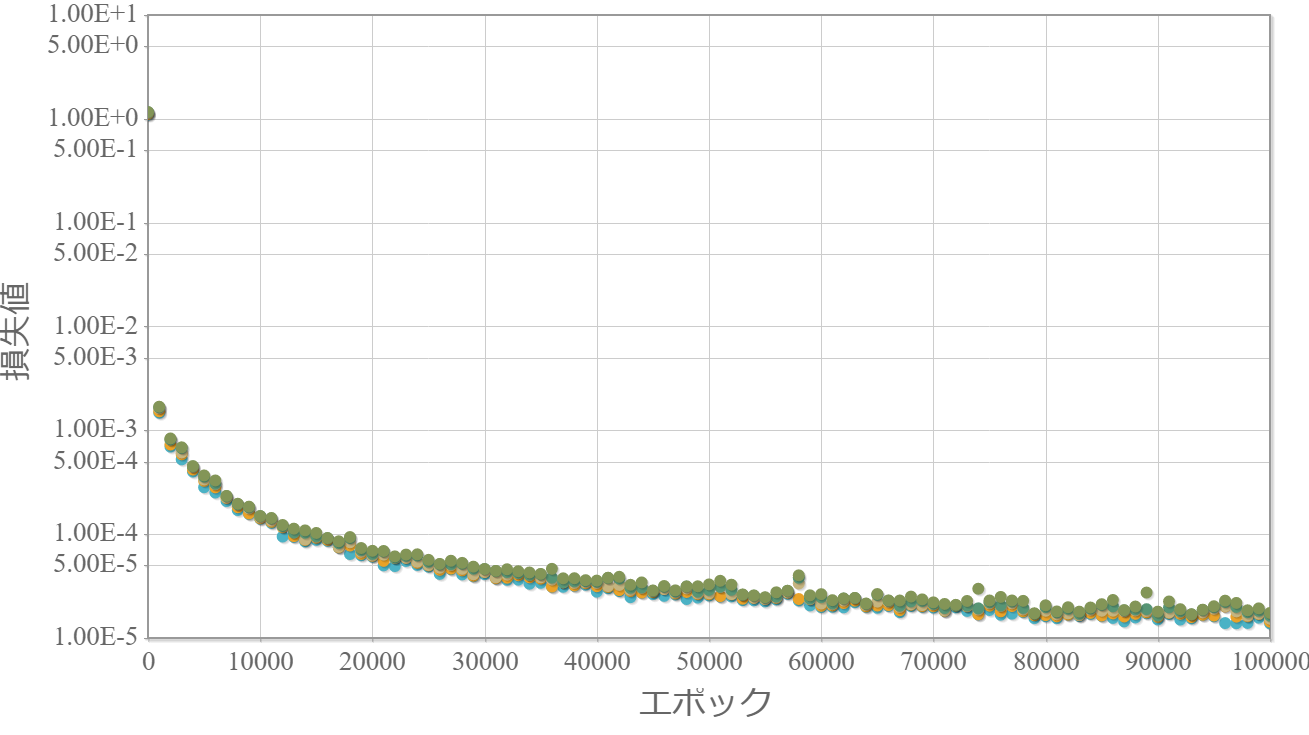

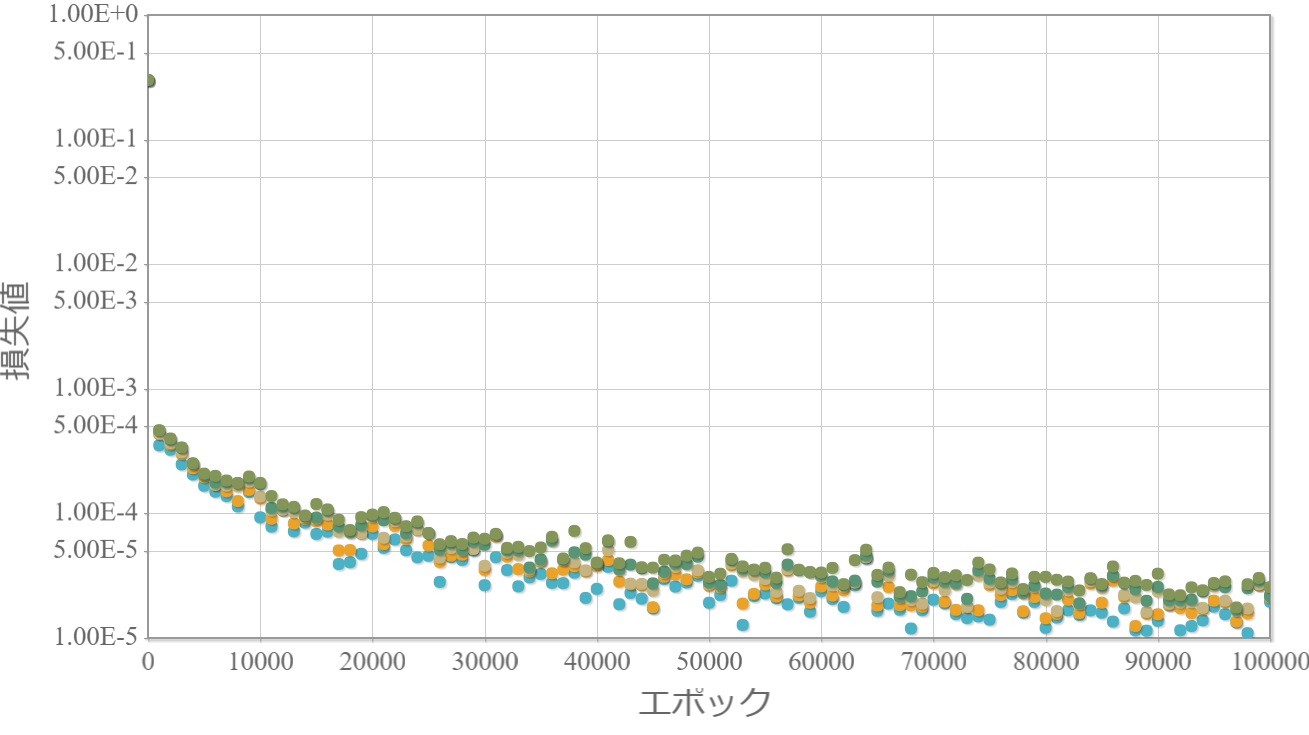

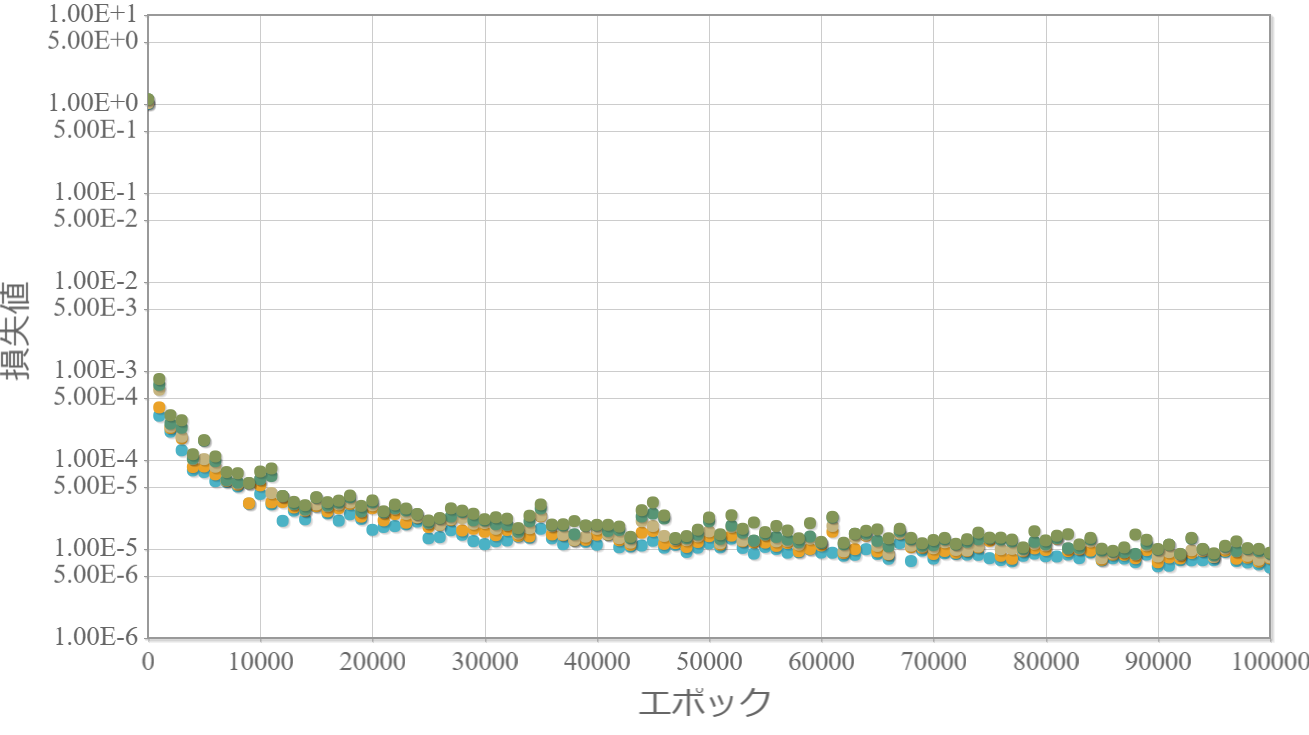

【2-100-100-100-100-100-100-100-100-1】型(中間8層)の比較

2次関数(係数が変化)

べき関数(指数が変化)

指数関数(底が変化)

考察

・意外にも学習対象とする関数形の違いはあまりない。

→ 関数形が単調増加(or 単調減少)の場合には違いは現れないのかもしれない。

・それにしても高々1変数の関数でも、精度の高い学習が大変であることがわかる。

→ 構造の抜本的な改善が必要があると言える。